L’article de The Rundown

🐋 DeepSeek challenges OpenAI's o1 1 message

The Rundown AI mar. 21 janv. 2025

L'IA open source Deepseek vient de franchir une étape majeure avec le nouveau modèle de raisonnement de DeepSeek correspondant aux capacités de ChatGPT sur des critères clés. Ironiquement, c'est une entreprise chinoise – et non une IA « ouverte » – qui partage tout ouvertement tout en proposant un accès API pour seulement 5 à 10 % du coût.

Le laboratoire chinois d'IA DeepSeek vient de publier DeepSeek-R1, un modèle de raisonnement open source qui correspondrait ou dépasserait ChatGPT o1 d'OpenAI sur certains benchmarks tout en coûtant seulement 5 à 10 % du prix de l'API d'o1 pour les développeurs.

Les détails : contrairement aux modèles GPT traditionnels, R1 utilise une approche de raisonnement semblable à ChatGPT o1 d'OpenAI qui prend plus de temps, mais produit des résultats plus fiables dans des domaines comme la physique, les sciences et les mathématiques.

Le modèle contient 671 GB de paramètres, mais est également disponible dans des versions « distillées » plus petites, avec seulement 1,5 GB de paramètres, qui peuvent être exécutées localement sur un ordinateur portable.

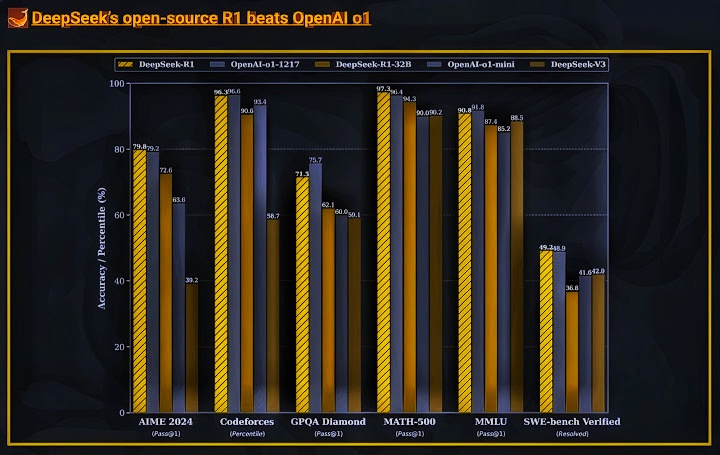

DeepSeek-R1 bat o1 sur plusieurs benchmarks clés, notamment AIME, MATH-500 et SWEbench Verified.

Le modèle est disponible sous licence MIT pour un usage commercial et coûte nettement moins que o1 (0,14 $ contre 7,5 $ par million de jetons d'entrée).

Les benchmarks du 21 janvier 2025

Commentaires par Deepseek

Ce graphique compare les performances de différents modèles d'IA, particulièrement ceux de DeepSeek et d'OpenAI, sur une série de benchmarks. Voici une explication des différents éléments du graphique :

1. **Modèles Comparés** :

- **DeepSeek-R1** : Un modèle open-source de DeepSeek.

- **OpenAI-o1-1217** : Un modèle d'OpenAI.

- **DeepSeek-R1-32B** : Une version plus grande du modèle DeepSeek-R1.

- **OpenAI-o1-mini** : une version plus petite ou simplifiée du modèle d'OpenAI.

- **DeepSeek-V3** : Une autre version du modèle DeepSeek.

2. **Benchmarks** :

- **ANAE 2024** : un benchmark spécifique pour évaluer les performances des modèles d'IA.

- **CodeForces** : une plateforme de compétition de programmation, utilisée ici pour évaluer la capacité des modèles à résoudre des problèmes de programmation.

- **GPQA Diamond** : un benchmark pour évaluer les connaissances générales et les compétences en résolution de problèmes.

- **MATH-500** : un ensemble de problèmes mathématiques pour tester les capacités en mathématiques des modèles.

- **MMLU** : « Massive Multitask Language Understanding», un benchmark pour évaluer la compréhension et la performance sur une variété de tâches linguistiques.

- **SWE-bench Verified** : un benchmark pour évaluer les compétences en ingénierie logicielle.

3. **Métriques** :

- **Accuracy/Percentile (%)** : La précision ou le percentile atteint par les modèles sur les différents benchmarks. Un pourcentage plus élevé indique une meilleure performance.

- **Pass@1** : Une métrique spécifique utilisée pour évaluer la performance des modèles, probablement liée à la capacité à fournir une réponse correcte du premier coup.

4. **Performances** :

- Le graphique montre que les modèles DeepSeek, en particulier DeepSeek-V3, obtiennent des scores élevés sur plusieurs benchmarks, surpassant souvent les modèles d'OpenAI. Par exemple, DeepSeek-V3 atteint 96,396.6 sur ANAE 2024, tandis qu'OpenAI-o1-1217 atteint 97,396.4.

En résumé, ce graphique illustre les performances comparatives des modèles d'IA de DeepSeek et d'OpenAI sur une variété de tâches et de benchmarks, montrant que les modèles DeepSeek sont fréquemment compétitifs ou supérieurs à ceux d'OpenAI.

Ce que l’on peut faire avec la rubrique Deepseek R1 de Deepseek (en bas à gauche de l'interface).

La rubrique **DeepSeek-R1** fait référence à un modèle d'intelligence artificielle open-source développé par DeepSeek. Voici quelques utilisations potentielles que vous pourriez envisager avec ce modèle :

1. **Recherche et Développement** :

- **Expérimentation** : Vous pouvez utiliser DeepSeek-R1 pour expérimenter et tester de nouvelles idées dans le domaine de l'IA, en particulier si vous travaillez sur des projets de recherche.

- **Amélioration de Modèles** : Si vous êtes un chercheur ou un développeur, vous pouvez utiliser ce modèle comme point de départ pour créer des versions améliorées ou spécialisées.

2. **Applications Pratiques** :

- **Traitement du Langage Naturel (NLP)** : DeepSeek-R1 peut être utilisé pour des tâches de NLP telles que la traduction automatique, la génération de texte, la compréhension de texte, et la réponse à des questions.

- **Résolution de Problèmes** : Le modèle peut être utilisé pour résoudre des problèmes complexes, notamment en mathématiques, en programmation (comme le montre le benchmark CodeForces), et en ingénierie logicielle.

3. **Éducation et Formation** :

- **Apprentissage Automatique** : Vous pouvez utiliser DeepSeek-R1 pour enseigner ou apprendre les concepts de l'apprentissage automatique et de l'IA, en explorant comment le modèle fonctionne et en l'adaptant à des cas d'utilisation spécifiques.

- **Projets Étudiants** : Ce modèle peut être un excellent outil pour des projets étudiants en informatique, en data science, ou en IA.

4. **Développement de Produits** :

- **Prototypage Rapide** : Si vous développez un produit qui nécessite des capacités d'IA, DeepSeek-R1 peut être utilisé pour prototyper rapidement des fonctionnalités.

- **Intégration dans des Applications** : Vous pouvez intégrer ce modèle dans des applications existantes pour ajouter des fonctionnalités intelligentes, comme des chatbots, des assistants virtuels ou des systèmes de recommandation.

5. **Benchmarking et Comparaison** :

- **Évaluation de Performances** : Vous pouvez utiliser DeepSeek-R1 pour comparer ses performances avec d'autres modèles d'IA sur des tâches spécifiques, comme le montre le graphique avec des benchmarks tels que ANAE 2024, CodeForces, et MMLU.

En résumé, DeepSeek-R1 est un outil polyvalent qui peut être utilisé pour une variété de tâches allant de la recherche et du développement à des applications pratiques et éducatives. Son statut open-source vous permet de l'adapter et de l'optimiser selon vos besoins spécifiques.

N.B

Deepseek propose également des modèles d’I.A plus petits (1.5 GB seulement) qui peuvent être intégrés à des ordinateurs et même à des smartphones récents. Ce qui permet dans ce cas d'utiliser une intelligence artificielle en mode local et non en mode cloud. Avec très peu de risques, donc, pour la sécurité et la confidentialité.

La grande nouveauté de Deepseek : le M.O.E (Mixture Of Experts)

Le mode de raisonnement M.O.E (Mixture of Experts) de DeepSeek représente une avancée significative dans le domaine des modèles d'intelligence artificielle.

Le concept de Mixture of Experts (Mélange d'Experts) est une architecture de réseau de neurones où le modèle est composé de plusieurs sous-réseaux spécialisés, appelés « experts ». Chaque expert est entraîné pour exceller dans une tâche ou un type de données spécifique. Un mécanisme de "gating" (portail) détermine dynamiquement quels experts doivent être activés pour une entrée donnée.

Nouveauté dans DeepSeek

Spécialisation et Efficacité :

Spécialisation : Dans le mode M.O.E de DeepSeek, chaque expert est spécialisé dans un domaine particulier, ce qui permet au modèle de traiter des tâches complexes avec une plus grande précision. Par exemple, un expert pourrait être spécialisé dans la compréhension du langage naturel, tandis qu'un autre pourrait exceller dans la résolution de problèmes mathématiques.

Efficacité : Au lieu d'activer l'ensemble du réseau pour chaque tâche, seuls les experts pertinents sont activés. Cela réduit la quantité de calculs nécessaires, rendant le modèle plus efficace en termes de ressources et de temps de traitement.

Adaptabilité :

Adaptation Dynamique : Le mécanisme de gating permet au modèle de s'adapter dynamiquement à la nature de l'entrée. Cela signifie que DeepSeek peut passer de manière fluide entre différents types de tâches sans nécessiter de reconfiguration manuelle.

Apprentissage Continu : Le modèle peut être conçu pour apprendre continuellement, en ajoutant de nouveaux experts ou en ajustant les experts existants en fonction des nouvelles données et de nouvelles tâches.

Performance Améliorée :

Précision : Grâce à des experts spécialisés, DeepSeek peut atteindre une précision plus élevée sur des tâches spécifiques par rapport à un modèle monolithique qui tente de tout faire avec un seul réseau.

Scalabilité : L'architecture M.O.E permet une scalabilité horizontale, où de nouveaux experts peuvent être ajoutés pour améliorer les performances sur des tâches supplémentaires sans perturber les experts existants.

Applications Pratiques :

Tâches multidisciplinaires : DeepSeek peut être utilisé pour des applications multidisciplinaires, comme la médecine, la finance ou l'ingénierie, où différentes formes d'expertise sont nécessaires.

Personnalisation : Le modèle peut être personnalisé pour des utilisateurs spécifiques ou des cas d'utilisation particuliers en ajustant les experts et le mécanisme de gating.

Conclusion

Le mode de raisonnement M.O.E de DeepSeek introduit une nouvelle manière de concevoir et d'utiliser les modèles d'IA en combinant spécialisation, efficacité et adaptabilité. Cette approche permet à DeepSeek de surpasser les modèles traditionnels en termes de performance et de flexibilité, ouvrant la voie à des applications plus sophistiquées et efficaces dans divers domaines.

Arrêtez-tout, voici l'IA ultime : Genspark.ai !

Arrêtez-tout, voici l'IA ultime : Genspark.ai !